En Bref : Jan est une application open-source qui fait tourner des IA de type ChatGPT 100% hors ligne sur votre ordinateur (PC, Mac, Linux). C’est une alternative puissante et respectueuse de la vie privée à des services cloud, idéale pour les développeurs et les passionnés de tech.

Fatigué de dépendre des serveurs de OpenAI ? Vous vous souciez de ce qu’il advient de vos données quand vous chattez avec une IA ? Ou peut-être que, comme moi, vous aimez juste avoir le contrôle total sur vos outils. Si vous vous reconnaissez là-dedans, alors Jan est probablement la solution que vous attendiez.

Depuis quelques mois, l’écosystème des IA locales est en pleine ébullition. Jan, anciennement connu sous le nom de « LlamaGPT », s’est rapidement imposé comme un acteur incontournable. Dans cet article, on va décortiquer ensemble ce que c’est, comment l’installer, et surtout, ce que ça vaut vraiment face à la concurrence. Accrochez-vous, on passe en mode local.

🤔 C’est quoi, Jan AI ? Plus qu’une simple alternative à ChatGPT

Jan se présente comme une « alternative open-source à ChatGPT qui tourne 100% hors ligne ». C’est une définition simple, mais qui cache une ambition bien plus grande. Plutôt qu’un simple « wrapper » pour des modèles de langage, Jan est une véritable plateforme de bureau pour interagir avec des IA génératives, sans jamais envoyer vos conversations sur le cloud.

Les 3 piliers de Jan : 100% Local, Open-Source et Extensible

Pour comprendre Jan, il faut retenir trois choses :

- 100% Local : Tout, du logiciel aux modèles de langage, en passant par vos conversations, reste sur votre machine. C’est la garantie d’une confidentialité totale. Pas de fuites de données, pas d’analyse de vos prompts par un tiers.

- Open-Source : Le code est disponible pour tous sur GitHub. C’est un gage de transparence et de sécurité. N’importe qui peut auditer le code, le modifier, et contribuer à son amélioration. C’est la force de la communauté.

- Extensible : Jan est conçu pour être modulaire. Il peut non seulement servir d’interface de chat, mais aussi de serveur d’inférence local, compatible avec l’API d’OpenAI. En clair, vous pouvez l’utiliser comme backend pour vos propres applications.

À qui s’adresse vraiment cet outil ?

Si Jan peut être utilisé par n’importe qui, il brille particulièrement pour certains profils :

- Les développeurs : Pour prototyper et développer des applications basées sur l’IA sans frais d’API et avec un contrôle total sur l’environnement.

- Les chercheurs et étudiants : Pour expérimenter avec différents modèles de manière privée et abordable.

- Les utilisateurs soucieux de leur vie privée : Pour tous ceux qui veulent profiter de la puissance des LLMs sans compromettre leurs données personnelles ou professionnelles.

🚀 Installation et Premier Lancement : Votre IA en 5 minutes chrono

L’un des gros points forts de Jan, c’est sa simplicité d’installation. L’équipe a fait un super boulot pour rendre l’expérience aussi fluide que possible.

Prérequis matériel : de quoi avez-vous besoin ?

Pas besoin d’un supercalculateur, mais il faut quand même une machine décente.

- RAM : 16 Go est un minimum confortable pour faire tourner des modèles de taille moyenne (7 milliards de paramètres). Avec 32 Go ou plus, vous serez beaucoup plus à l’aise pour les modèles plus gros.

- Stockage : Prévoyez quelques dizaines de Go d’espace libre. Les modèles pèsent lourd (entre 4 Go et plus de 70 Go).

- GPU (Optionnel mais recommandé) : Si vous avez une carte graphique dédiée (NVIDIA de préférence), les performances seront décuplées. Sinon, Jan utilisera votre processeur (CPU), mais ce sera plus lent.

Guide d’installation (Windows, macOS, Linux)

- Rendez-vous sur le site officiel de Jan.

- Téléchargez l’installeur correspondant à votre système d’exploitation.

- Lancez-le et suivez les instructions. C’est aussi simple que d’installer n’importe quelle autre application.

Premier contact : l’interface et le téléchargement de votre premier modèle

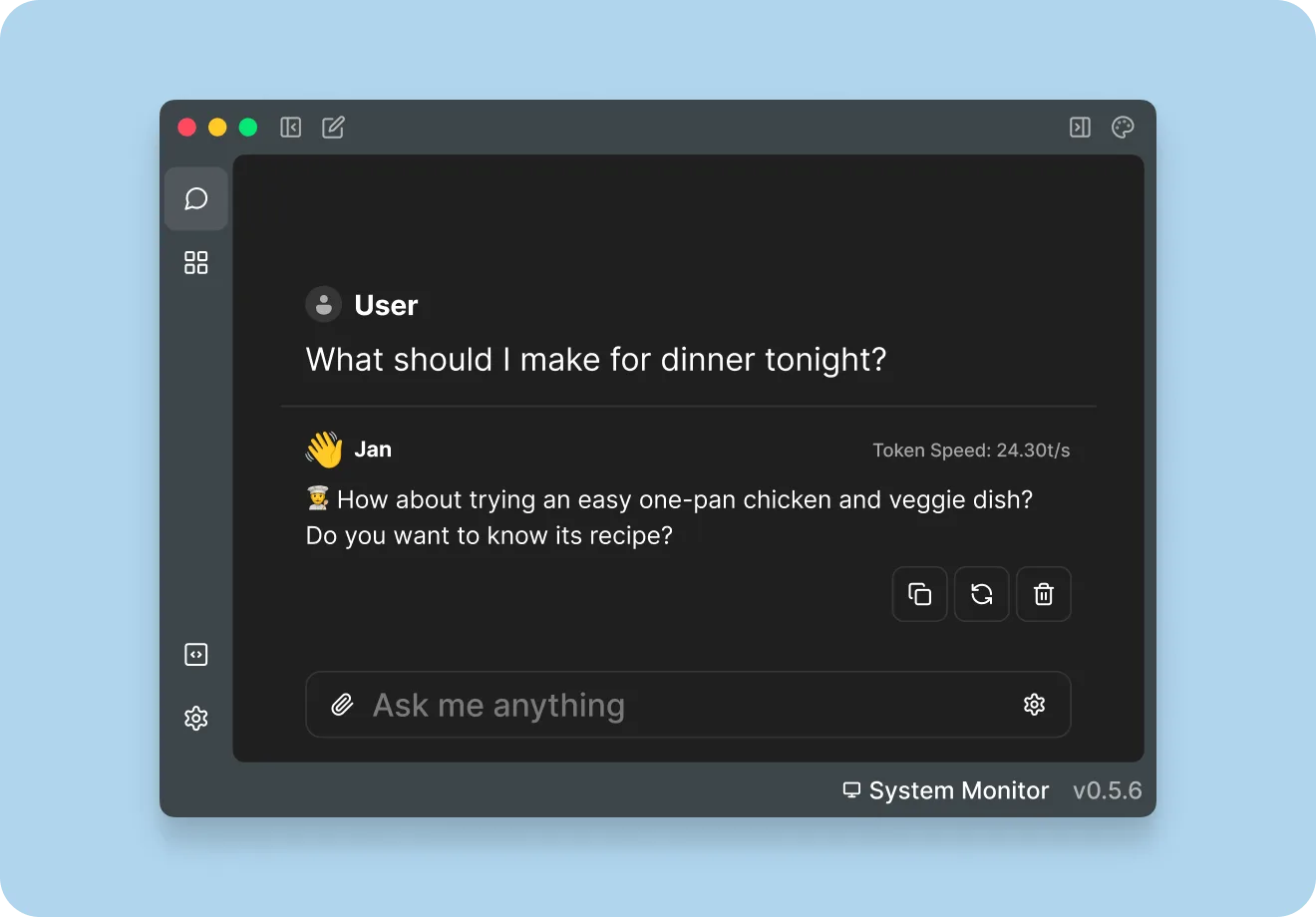

Une fois Jan lancé, vous êtes accueilli par une interface épurée. Sur la gauche, vos conversations. Au centre, la zone de chat. Mais avant de discuter, il faut un cerveau à notre IA !

Dirigez-vous vers le « Hub ». C’est le catalogue de modèles de Jan. Pour commencer, je vous conseille un modèle polyvalent comme Mistral 7B Instruct ou Llama 3 8B Instruct. Cliquez sur « Download » et patientez. Une fois le téléchargement terminé, vous pouvez lancer votre première conversation. C’est tout !

Insight : GGUF, le format de modèle à connaître

Vous verrez souvent l’acronyme GGUF. C’est le format de fichier utilisé par la plupart des IA locales. Créé par l’équipe derrière llama.cpp, il permet de « quantizer » un modèle, c’est-à-dire de réduire sa taille et les ressources nécessaires pour le faire tourner, avec une perte de précision souvent minime. C’est grâce à ce format que l’on peut faire tourner des IA aussi puissantes sur des ordinateurs personnels.

🥊 Jan AI vs. la Concurrence : Le Match des IA Locales

Jan n’est pas seul sur le ring. Ses deux principaux concurrents sont Ollama et LM Studio. Alors, lequel choisir ?

| Critère | Jan | Ollama | LM Studio |

|---|---|---|---|

| Facilité d’usage | ✅✅✅ (Interface graphique complète) | ✅ (Ligne de commande, API) | ✅✅✅ (Interface graphique complète) |

| Fonctionnalités | Chat, Serveur API, Gestion de modèles | Serveur API, Ligne de commande | Chat, Recherche de modèles, Réglages fins |

| Philosophie | Plateforme tout-en-un | Outil minimaliste pour développeurs | « IDE » pour explorer les LLMs |

| Open Source | Oui | Oui | Non |

Jan vs. Ollama : L’expérience utilisateur avant tout

Ollama est un outil fantastique, mais il s’adresse avant tout aux développeurs à l’aise avec la ligne de commande. Jan, lui, propose une expérience « out-of-the-box » avec une interface graphique léchée. C’est plus accessible pour débuter.

Jan vs. LM Studio : Deux philosophies différentes

LM Studio est excellent pour explorer et tester finement des modèles, avec une interface très riche en réglages. Jan se concentre sur une expérience plus directe et intégrée, avec en prime la capacité de se transformer en serveur API et son caractère entièrement open-source, un avantage majeur sur LM Studio qui est propriétaire.

🛠️ Aller plus loin avec Jan : Les fonctionnalités qui changent la donne

Là où Jan devient vraiment intéressant, c’est quand on explore ses fonctions avancées.

Utiliser Jan comme un serveur API (compatible OpenAI)

C’est LA killer feature pour les développeurs. En un clic dans les paramètres, Jan démarre un serveur local sur le port 1337. Ce serveur expose une API qui est 100% compatible avec celle d’OpenAI.

Concrètement, ça veut dire que vous pouvez prendre n’importe quel code qui utilise l’API de gpt-3.5-turbo ou gpt-4, changer juste l’URL de base pour http://localhost:1337/v1, et votre application fonctionnera avec votre modèle local. Sans rien changer d’autre. C’est incroyablement puissant.

Personnalisation avancée : les « threads » et les « assistants »

Jan intègre la notion de « Threads » (fils de discussion) et d' »Assistants », un peu comme l’API d’OpenAI. Vous pouvez créer des assistants avec des instructions spécifiques (par exemple, « Tu es un expert en Python ») pour les réutiliser dans différentes conversations.

Contribuer au projet : la force de l’open-source

Le projet est très actif sur GitHub. Si vous avez des compétences en développement, n’hésitez pas à jeter un œil au dépôt GitHub du projet, à remonter des bugs ou même à proposer des améliorations.

✅ Mon Avis sur Jan AI : Faut-il l’adopter en 2025 ?

Après plusieurs semaines à l’utiliser au quotidien, à la fois comme outil de chat et comme serveur de dev local, mon verdict est très positif.

Les points forts : ce que j’ai adoré

- La simplicité : C’est de loin l’outil le plus simple à prendre en main pour une expérience « ChatGPT-like » en local.

- La polyvalence : Le duo interface de chat + serveur API est un game-changer.

- Le 100% Open-Source : C’est un critère essentiel pour un outil qui manipule des données potentiellement sensibles.

- La réactivité du projet : Les mises à jour sont fréquentes et la communauté est active.

Les points faibles : là où ça peut encore s’améliorer

- La consommation de ressources : Forcément, faire tourner un LLM, ça consomme. L’application peut parfois être gourmande en RAM.

- Moins de réglages fins : Comparé à LM Studio, il y a moins d’options pour « tuner » le modèle à la volée. C’est un choix de simplicité, mais les experts pourraient se sentir limités.

En conclusion, Jan a trouvé une place de choix sur mon dock. C’est devenu mon réflexe pour toutes les tâches qui ne nécessitent pas la puissance brute (et le coût) d’un GPT-4, mais où la confidentialité est primordiale.

❓ FAQ – Vos questions sur Jan AI

Quels sont les meilleurs modèles à utiliser avec Jan ?

Pour un bon équilibre performance/qualité, les modèles de la famille Mistral (7B) et Llama 3 (8B) sont d’excellents points de départ. Si vous avez une configuration musclée, vous pouvez tenter des modèles plus gros comme Mixtral 8x7B. Le meilleur endroit pour en découvrir d’autres reste Hugging Face.

Jan AI est-il vraiment gratuit ?

Oui, Jan est 100% gratuit et open-source. Les seuls « coûts » sont l’électricité consommée par votre ordinateur et l’espace de stockage pour les modèles.

Puis-je utiliser Jan sans connexion internet ?

Absolument ! Une fois que vous avez téléchargé l’application et au moins un modèle, vous pouvez couper votre connexion Wi-Fi. Jan fonctionnera parfaitement en circuit fermé sur votre machine. C’est l’un de ses plus grands avantages.